Suchmaschinen wie Google setzen auf Web Crawling, um Seiten im Suchindex aufzulisten. Soziale Netzwerke wie Facebook verwenden Crawling, um dir die optimalsten Beiträge in deinem Newsfeed zu präsentieren. Amazon nutzt es zum Crawlen von Produktseiten. Crawling ist also integraler Bestandteil des Internetbetriebs, wie wir ihn kennen. Nun stellt sich die Frage: Welchen Nutzen kannst du daraus ziehen? Wie kann Crawling dir bei deinen alltäglichen Herausforderungen helfen? Genau darum geht es in diesem Beitrag. Du wirst lernen, wie du mit Crawling Datensätze ergänzen kannst, um beispielsweise Preisvergleiche durchzuführen.

Web Crawling – Was ist das?

Crawling ist der automatisierte Prozess des Durchsuchens und Sammelns von Informationen von Internetseiten. Ein Website-Crawler ist eine automatisierte Software, die zum Navigieren auf Webseiten, zum Extrahieren und zum Speichern von Daten verwendet wird.

Und was ist Web-Scraping?

Web-Scraping bezeichnet das automatisierte Auslesen von Daten auf Webseiten, auch als Data-Scraping bekannt. Im Gegensatz zum Web-Crawling fokussiert sich Web-Scraping auf spezifische Daten, die du extrahieren möchtest und speichert sie in einem strukturierten Format, z. B. in einer Datenbank oder Excel-Datei.

Web-Scraping wird häufig verwendet, um Kontaktinformationen, Produktdetails, Bewertungen und Preise zu extrahieren. Es wird oft von Datenwissenschaftlern und Forschern genutzt, um große Datenmengen für Analysen oder maschinelles Lernen zu sammeln.

Wie hängen Web Scraping und Web Crawling zusammen?

Obwohl Crawling und Scraping unterschiedliche Ziele verfolgen, können sie zusammen verwendet werden. Crawling dient zum Auffinden und Indizieren von Webseiten, während Scraping dazu dient, Daten von diesen Seiten zu extrahieren. Durch die Kombination beider Verfahren kannst du ein leistungsfähiges Data Harvesting-System erstellen, das spezifische Informationen von Hunderten oder sogar Tausenden von Seiten gleichzeitig sammelt.

Wozu braucht man Crawling und Scraping?

Das World Wide Web bietet nahezu unbegrenzte Informationen. Der Prozess des manuellen Auslesens ist jedoch ressourcen- und zeitaufwendig. Webseiten müssen manuell aufgerufen, benötigte Informationen gesucht, identifiziert und zusammengetragen werden. Hier kann ein Web Crawler helfen. Er automatisiert den Prozess und liefert Daten bereit zum Gebrauch, sodass du dich auf deine Kernaktivitäten konzentrieren kannst.

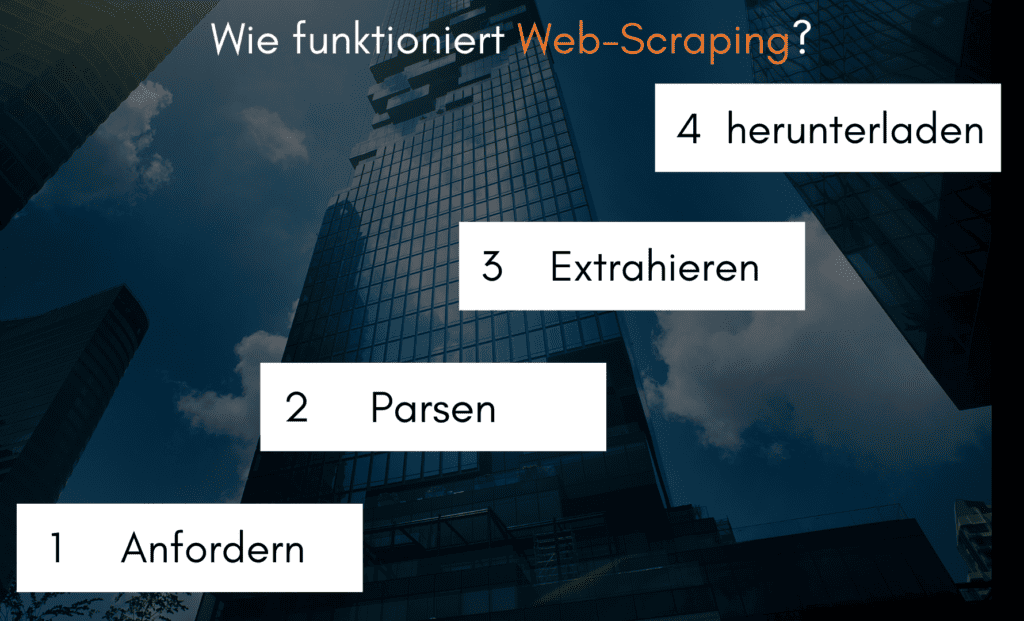

Wie ist die Funktionsweise Web-Scraping?

Der Web-Scraping-Prozess umfasst drei Schritte: Anforderung, Parsen und Extrahieren sowie Datenherunterladen.

Was ist Web-Scraping?

Der Web-Scraping-Prozess besteht aus drei Schritten: Anfordern, Parsen und Extrahieren sowie Herunterladen von Daten.

- In der ersten Phase fordert der Web Scraper die Inhalte einer bestimmten URL von der Ziel-Webseite an. Daraufhin erhält der Scraper die angefragten Informationen in HTML-Format.

- Die zweite Phase, das Parsen und Extrahieren, beinhaltet das Durchforsten des Codes, um relevante Informationen wie Titel, Absätze, Überschriften, Links und fettgedruckten Text auszulesen – ein Prozess, der auch als HTML-Parsing bezeichnet wird.

- In der abschließenden Phase werden die Daten heruntergeladen und entweder in einer CSV-, JSON- oder Datenbankdatei gespeichert. Die so gesammelten Daten können dann abgerufen und entweder manuell genutzt oder in andere Programme eingefügt werden.

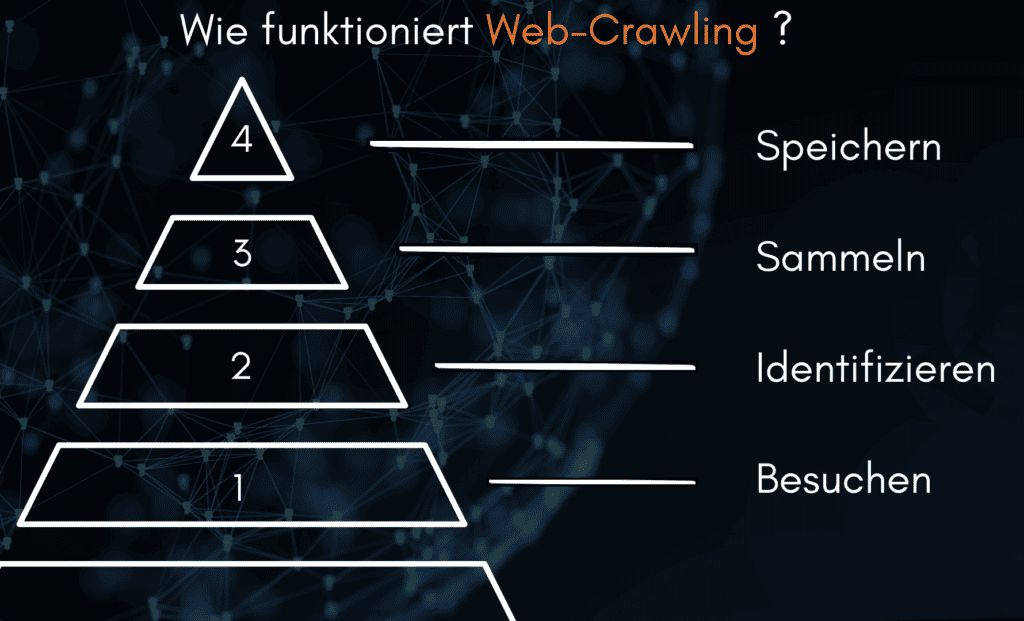

Wie funktioniert Web-Crawling?

Der Prozess des Web-Crawling umfasst vier Hauptphasen:

- Zunächst navigiert der Crawler zu einer bestimmten URL und analysiert deren Inhalt.

- Anschließend erkennt er sämtliche Verlinkungen auf der Seite und besucht diese, um den vorangegangenen Schritt zu replizieren.

- Während des fortlaufenden Besuches sammelt der Crawler mit der Zeit kontinuierlich mehr Daten von den Seiten.

- Abschließend werden diese Daten vom Crawler erfasst und in einem nutzbaren Format aufbereitet und gespeichert.

Welche Tools gibt es für Web-Crawling?

Es gibt eine Reihe von Web-Crawling-Tools, die von Open-Source-Frameworks wie Scrapy bis hin zu Unternehmenslösungen wie Apache Nutch variieren. Mit diesen Instrumenten kannst du effizient und automatisiert Webseiten durchsuchen und Daten abrufen, eine deutliche Verbesserung gegenüber dem manuellen Scraping. Populäre Open-Source-Frameworks sind Selenium, Beautiful Soup und Requests. Unternehmenslösungen bieten in der Regel zusätzliche Funktionen wie die Steuerung umfangreicher Crawls, die Kontrolle der Crawling-Ergebnisse und Exportmöglichkeiten.

Scrapy ist ein weit verbreitetes Open-Source-Web-Crawling-Framework, das zur Datengewinnung von Webseiten eingesetzt wird. Es ist in Python verfasst und erlaubt das schnelle und effektive Durchsuchen großer Webseiten.

Selenium ist ein weiteres populäres Open-Source-Framework für Web-Scraping, das dir die Kontrolle über einen Browser gibt und das automatisierte Auslesen von Website-Inhalten ermöglicht.

Beautiful Soup ist eine Bibliothek zur Analyse von HTML-Dokumenten, die oft beim Web-Scraping eingesetzt wird. Sie bietet eine einfache und benutzerfreundliche Schnittstelle zum Navigieren und Extrahieren von Daten aus HTML-Dokumenten.

Requests ist eine HTTP-Bibliothek, die das Einholen von Webseiten mit Python-Code erleichtert. Sie erlaubt es, Anfragen einfach zu stellen, Antworten zu analysieren und Daten zu speichern

Apache Nutch ist ein unternehmensweites Web-Crawling-Framework, das für Data Mining und Scraping eingesetzt wird. Es ist in Java geschrieben und bietet Funktionen wie die Steuerung großer Crawls, die Überwachung der Crawling-Ergebnisse und Exportmöglichkeiten.

Das Entwickeln eines Web-Scrapers bzw. Web-Crawlers kann technisch anspruchsvoll sein. Daher empfehlen wir eine Zusammenarbeit mit einem spezialisierten Dienstleister.

https://scrapingexperts.de/kontakt/

Dies sind nur einige der verfügbaren Instrumente für das Web-Scraping. Mit ihrer Hilfe kannst du mühelos Daten von Webseiten abrufen und für weitere Verwendung mit anderen Applikationen aufbereiten.

Welche Werkzeuge stehen für Web-Scraping zur Verfügung?

Es gibt viele unterschiedliche Tools für das Web-Scraping, abhängig vom konkreten Anwendungsfall. Einige der bekanntesten beinhalten:

- ProWebScraper ist eine nutzerfreundliche Plattform für das Extrahieren von Daten aus Websites. Sie bietet eine Point-and-Click-Oberfläche und erfordert keine Vorkenntnisse in der Programmierung, um mit der Arbeit zu beginnen.

- Webscraper.io ist eine Erweiterung für Chrome, die es den Nutzern ermöglicht, unkompliziert Daten von Websites zu gewinnen. Sie erstellt Sitemaps, die darstellen, wie die Website durchsucht und welche Informationen extrahiert werden sollen.

Anwendungsbereiche des Web-Crawlings

Web-Crawling findet Anwendung in Bereichen wie Data Mining, Sentiment-Analyse, Preisvergleichen und Wettbewerbsbeobachtung. Informationen können von verschiedenen Quellen zusammengetragen werden, um einen umfangreichen Überblick über ein spezifisches Thema oder einen bestimmten Markt zu gewinnen. Datenwissenschaftler nutzen Web-Crawling für prädiktive Analysen und Machine-Learning-Modelle.

Web-Crawler können auch für automatisierte Tests oder die Performance-Überwachung von Websites eingesetzt werden. Sie sind in der Lage, mehrere Websites gleichzeitig zu durchsuchen und Probleme wie tote Links, langsam ladende Seiten oder fehlerhafte Inhalte zu identifizieren.

Darüber hinaus können sie genutzt werden, um Veränderungen von Web-Inhalten über die Zeit hinweg zu überwachen und durch die Analyse Trends zu erkennen.

Anwendungsbereiche des Web-Scraping

Web-Scraping kann auch für Lead-Generierung, Talentsuche, Social-Media-Überwachung und mehr genutzt werden. Mit Web-Scraping können Unternehmen Datenerfassungsprozesse automatisieren und in einem Bruchteil der Zeit, die für eine manuelle Erfassung benötigt würde, wertvolle Erkenntnisse gewinnen. Web-Scraping ist ein unbezahlbares Instrument für jedes Unternehmen, das die Vorteile des Internets nutzen möchte. Zu den häufigsten Anwendungen gehören:

Inhaltsaggregation

Web Scraper können dazu genutzt werden, Daten von mehreren Websites zu sammeln und diese in einem umfassenden Bericht oder einer Datenbank zusammenzufassen.

Marktforschung

Mit Web-Scraping können Daten über spezifische Produkte, Preise, Wettbewerber, Kundenmeinungen und mehr extrahiert werden. Diese Informationen können dann für Marktanalysen herangezogen werden.

Suchmaschinenoptimierung (SEO)

Durch Web-Scraping können herausgefunden werden, welche Schlüsselwörter und Phrasen von deiner Zielgruppe genutzt werden, wodurch du den Inhalt deiner Website optimieren kannst..

Lead-Generierung

Web-Scraping kann Unternehmen dabei unterstützen, Kontaktdaten von potenziellen Kunden zu finden, etwa E-Mail-Adressen, Telefonnummern und Profile in sozialen Medien. Diese Daten können dann für gezieltes Marketing genutzt werden.

Talentsuche

Unternehmen können Web Scraping nutzen, um nach Bewerbern zu suchen, einschließlich ihrer Kontaktinformationen und früheren Berufserfahrung.

Überwachung sozialer Medien

Nutze Web Scraping, um Trends auf Social-Media-Plattformen zu überwachen und wertvolle Erkenntnisse über das Kundenverhalten zu gewinnen.

Maschinelles Lernen

Web Scraping wird verwendet, um große Datenmengen zu sammeln, die zum Trainieren von maschinellen Lernmodellen verwendet werden können.

Fazit

Web-Crawling und Web-Scraping sind potente Instrumente zur Datensammlung aus dem Web. Sie können eine Vielzahl von Aufgaben automatisieren, darunter Marktforschung, Lead-Generierung, Talentakquise und Überwachung von sozialen Medien. Mit dem Fortschritt der Technologie wird Web-Scraping zunehmend wertvoller für Unternehmen, die tiefere Erkenntnisse in ihre Märkte oder Kundengruppen erlangen möchten.

Häufig gestellte Fragen (FAQs)

Web Crawling, auch als Web Scraping oder Data Mining bekannt, ist ein Prozess zur Gewinnung von Daten von Websites, bei dem Computerprogramme genutzt werden, um spezifische Informationen auf einer Webseite zu finden und zu extrahieren.

Die Vorteile von Web Crawling umfassen automatische Datensammlung, Lead-Erzeugung, Marktforschung und Überwachung von sozialen Medien.

Web Scraping wird häufig für verschiedene Zwecke genutzt, darunter die Aggregation von Inhalten, Marktforschung, Suchmaschinenoptimierung, Lead-Generierung, Talentakquisition und Monitoring von sozialen Medien. Es findet auch Anwendung in maschinellem Lernen und Forschungsbereichen.

Web Scraping wird allgemein als legal angesehen, solange es im Einklang mit den geltenden Gesetzen steht. Es ist allerdings wichtig, die Nutzungsbedingungen jeder Webseite, die Du scrapen möchtest, zu überprüfen, da einige Webseiten diese Praxis ausdrücklich untersagen.

Web Crawling bezieht sich auf den Prozess der automatisierten Navigation durch Webseiten zur Datensammlung, während Web Scraping den Vorgang des Extrahierens spezifischer Informationen von Webseiten beschreibt. Beide Techniken werden kombiniert, um große Mengen an Daten aus unstrukturierten Quellen im Internet zu sammeln.

Ja, es gibt Risiken. Wenn Du nicht vorsichtig bist, könntest Du urheberrechtlich geschützte Daten extrahieren. Darüber hinaus können einige Webseiten IP-Adressen blockieren, die automatisiert Daten sammeln. Daher ist es wichtig, beim Web Scraping entsprechende Vorkehrungen zu treffen.